Que pensez-vous des groupes de niveau à l'école ?

Des groupes de niveau vont être mis en place en 6ième et 5ième (Enfants de 11 et 12 ans) en français et en mathématique(1). A cet âge en France tous les enfants suivent le même cursus, il n'y a pas encore d'orientation dans des filières différentes.

La classe demeure l’organisation de référence pour les élèves et les professeurs dans l’ensemble des disciplines autres que le français et les mathématiques, soit les deux tiers du temps scolaire de l’élève.

Afin de permettre aux équipes éducatives de faire davantage progresser tous les élèves, les enseignements de mathématiques et de français sont organisés en groupes, communs à plusieurs classes, sur la totalité de l’horaire hebdomadaire. Pour l’ensemble des groupes, les programmes et les attendus de fin d’année sont identiques.

Les groupes qui comportent un nombre important d’élèves en difficulté sont en effectifs réduits, le nombre d’une quinzaine d’élèves pou...Continuer à lire

Le retour des hirondelles et des martinets noirs, édition 2025

Il y a exactement un an aujourd'hui, je vous demandais si les hirondelles et les martinets noirs étaient de retour par chez vous : https://vortext.eu/Page-de-reponses/207/les-hirondelles-et-martinets-sont-ils-de-retour-par-chez-vous

Hier, j'ai pu voir les premiers martinets noirs de retour dans mon quartier, et je suis en train de les entendre actuellement. J'irai à Werder en fin de semaine, où je verrai certainement des hirondelles.

Pour célébrer cela, je vous repose donc exactement la même question cette année : les hirondelles et martinets sont-ils de retour par chez vous ? 😄

La solution des stations relais applicable à l'automobile ?

Une solution a été mise en place pour permettre le transport des marchandises par camion électrique sur une distance de 900 km.

Le fonctionnement est simple : un camion électrique arrive en station, détache sa remorque, et un second véhicule, prêt à repartir, prend aussitôt le relais. Pendant que le premier recharge ses batteries, il récupère une autre remorque pour un trajet retour. « L’utilisation de camions électriques sur des segments autoroutiers d’environ 300 km permet de contourner les contraintes opérationnelles d’autonomie », expliquent les trois partenaires(1).

Est-ce que cela ne pourrait pas être appliqué d'une manière ou d'une autre aux voitures ?

Il y a au moins trois pistes possibles.

- Changer de voiture

- Dissocier le moteur et l'habitacle, et accoupler l'habitacle avec un nouveau moteur

- Changer uniquement la batterie.

Que pensez-vous de tout cela ?

Continuer à lire

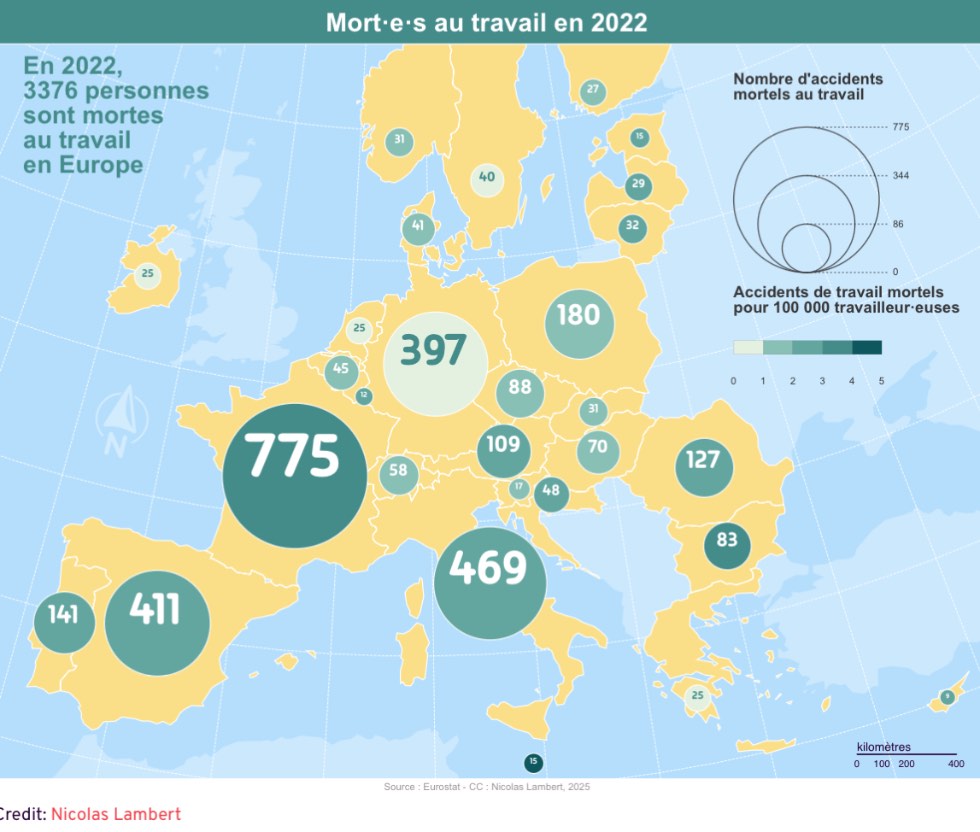

La sécurité au travail

Je viens de découvrir cet article : https://www.humanite.fr/en-debat/regard-de-cartographe/la-carte-interactive-qui-recense-les-morts-au-travail-en-europe

Voici la carte la plus récente (2022) de cet article :

On peut constater que le nombre de morts en France (775) est nettement plus élevé qu’en Espagne (411), en Italie (469), en Allemagne (397) ou en Pologne (180), alors que ces pays sont pourtant en tête du classement et présentent une démographie relativement comparable à celle de la France.

Selon vous, qu’est-ce qui explique un tel écart, et comment pourrait-on l’éviter à l’avenir ?

Quelles pourraient être les conséquences de The Big One (tremblement de terre sur la faille de San Andreas)?

Réponse à la question : Est-ce que notre société perd l'usage de l'écriture, et peut-être de la lecture ?

Rien n'est perdu ! Nous ajoutons des possibilités technologiques qui ne se substituent jamais entièrement aux anciennes technologies. Il est possible d'écrire dans le sable dans la démocratie athénienne et il est possible d'écrire dans le sable sur Facebook et de conserver ses écrits manuscrits ou sous forme de fichiers informatiques.

A chacun de nous de bien identifier son processus d'écriture !

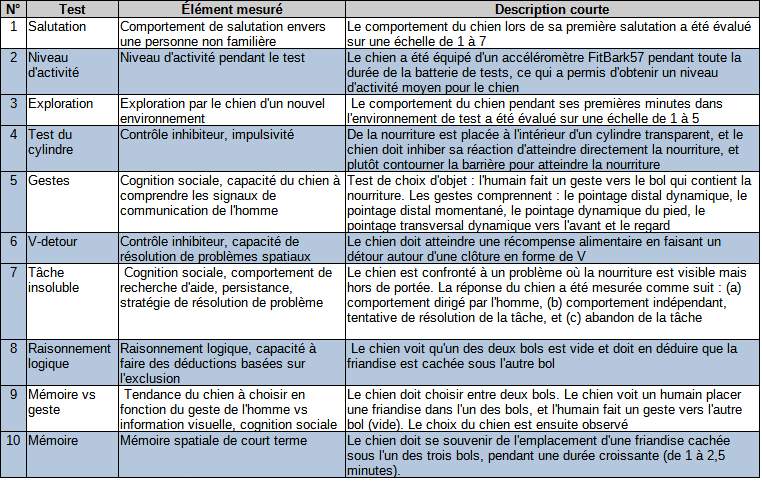

Que pensez-vous de ce test de QI pour chiens ?

J'ai découvert en lisant un article de Science Post (1) qu'il existait un test de QI supposé adapté aux chiens. Il est décrit dans l'article en anglais en lien (2) , mais voici une traduction (avec deepl.com) suivant deux formats.

- Une image

- Un tableau en annexe, que je ne sais pas mettre en forme correctement, pour les non-voyants et ceux qui trouveraient cela plus pratique.

Que pensez-vous du test ?

Auriez-vous des idées pour le QI des chats ?

(1)

Continuer à lire

Un jeu et une question sur l'or ?

Un jeu et une question sur l'or ?

Question : qu'évoque pour vous ce métal précieux ?

Jeu : essayez de ne pas utiliser les lettres "o" et "r" dans la réponse !

![Petit tas de bijoux en or ref europiecedor[.]fr](https://files.vortext.eu/file/vortext-images/556964igmdznsm9wndqn.jpg)

À votre avis, en quoi notre genre peut-il influencer notre orientation professionnelle ? Est-ce plutôt une question de culture, de physique ou d’hormones ?

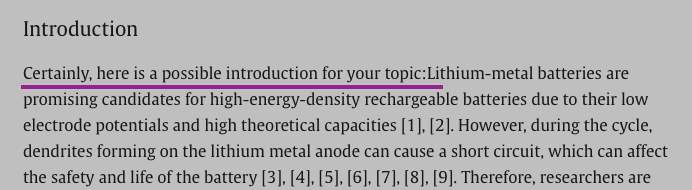

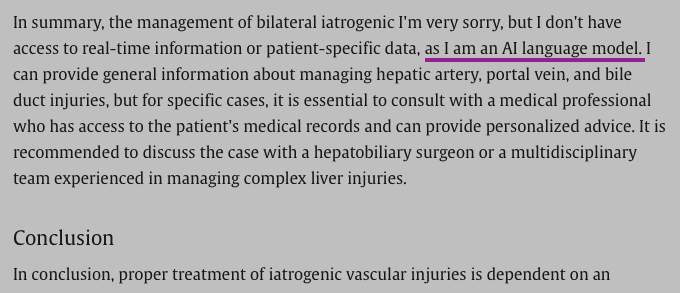

Utilisation de Chat GPT dans la publication d'articles de recherches scientifiques

Depuis plusieurs mois, on peut voir de plus en plus de publications de recherches scientifiques qui ont clairement été rédigé par Chat GPT. Voici ici deux exemples flagrants :

Cet article a été publié dans Surfaces and Interfaces en mars 2024. Vous pouvez le lire en entier depuis ce lien sur ScienceDirect. La première phrase de l'introduction est un indice évident de l'utilisation de ChatGPT.

Cet autre article sera publié dans le numéro de juin 2024 de Radiology Case Reports, mais a été accepté en février de cette année et est en ligne depuis début mars. Il est accessible depuis ce lien sur ScienceDirect.

Ça veut dire que des « chercheurs » malhonnêtes et incompétents demandent à ChatGPT de rédiger les articles à leur place et ne prennent même pas la peine de lire l'article généré (possibles barrières linguistiques). Ensuite, ça veut dire que l'éditeur n'a ni lu, ni compris l'article. Puis, ça veut dire que même la révision par les pairs a complètement été bâclée et que les pairs n'ont pas lu non plus l'article avant de l'approuver. Enfin, ça veut dire que même l'étape de correction (copy editing) qui vérifie les erreurs de langage, est passé outre cette énormité.

Mes questions sont les suivantes :

- Est-ce que ces chercheurs scientifiques trollent le système, quitte à se tirer une balle dans le pied et mettre fin à leur carrière, une fois la supercherie exposée ?

- Ce problème pourrait-il être une conséquence du système actuel, qui pousse les chercheurs dans une course effrénée à la publication et les éditeurs qui en profitent pour monnayer cette frénésie ?

- Quels seraient les moyens d'éradiquer ce problème si la relecture supposée par plusieurs entités n'est pas suffisante ?

- Quelles sont les conséquences à long terme pour la science ?

- Avez-vous d'autres exemples flagrants de ce type à partager ?

Pour pouvoir répondre à cette question, vous devez vous connecter.

La rédaction de papiers scientifiques par ChatGPT est un problème sérieux, parce que ChatGPT peut commettre des erreurs parfois graves. De plus il ne cite pas ses sources, ce qui expose à des plagiats. Je pense que les scientifiques sont conscients du problème, on voit souvent des discussions à ce sujet dans les revues scientifiques.

La compétition aux papiers et aux citations est aussi un problème, qui incite souvent des scientifiques à publier des résultats insuffisament consolidés, voire à tricher.

Comment y remédier? Les comités de lecture doivent savoir reconnaître les tics de Chat GPT (Il en a plusieurs). Et en cas de doute, interviewer ceux qui ont soumis le papier.

Bien entendu pour reconnaître un papier écrit par Chat GPT, il faut avoir l'habitude de discuter avec lui, au lieu de le bouder ou de le dénigrer. C'est une aide efficace et rapide pour tout un tas de tâches.

Les conséquences pour la science sont nombreuses, car elle adopte ainsi les défauts des concepteurs de ChatGPT. Voire elle se soumet à une entité unique, qui pourrait être tentée de biaiser ses résultats. (comme le font massivement d'autres grandes sociétés Internet).

Concernant l'exemple cité d'article bidonné par Chat GPT, il est gros, mais même avant d'arriver à "I am a AI model", on a déjà reconnu Chat GPT. L'exemple est gros, mais il y en a bien d'autres plus subtils.

Je ne connais pas cette revue Surfaces and Interfaces , mais il existe de nombreuses revues avides de publier sans trop vérifier, voire des revues prédatrices qui publient n'importe quoi et le contraire, notoirement sans vérification. Pour un non-scientifique, et même pour un scientifique débutant, il est difficile de déceler le piège.

Le problème étant le support, quelle est leur crédibilité comme revue ?

Et ca me semble vraiment se disqualifier ..

Analyse de l'article.

En lisant l'article je ne trouve pas que cela ressemble aux articles scientifiques que je peux lire plus souvent dans d'autres domaines, mais plus à un partage d'expérience dans le domaine de la chirurgie. L'opération décrite me semble plausible, mais je n'ai pas avis d'expert sur le sujet.

Cela ne ressemble pas aux textes de ChatGPT habituels, car ceux-ci ne citent pas leurs sources. Cela pourrait être une version plus évoluée permettant d'ajouter des sources à un article, sous réserve qu'on explique bien ce que l'on souhaite.

Des versions de ce type sont en cours de développement, ou déjà opérationnelles, à destination des entreprises.

Utilisation des outils de rédaction informatique.

Ce que je vois exposé concernant les outils comme ChatGPT grand public me montre que cela ne permet pas de répondre aux question. On n'a pas accès aux sources et à la logique du raisonnement, mais cela permet d'obtenir un texte à la rédaction consensuelle sur un sujet donné.

On s'amuse des erreurs concernant le fond du sujet, mais personne ne critique la qualité de rédaction. Elle ne choque pas. C'est à tel point que

Les livres numériques rédigés par ChatGPT affluent sur Amazon

[...]

Brett Schickler n'avait jamais imaginé qu'il pourrait devenir un auteur publié, même s'il en avait déjà rêvé. Mais l’arrivée de l'intelligence artificielle ChatGPT lui a fait saisir l’opportunité qui se présentait.

L'idée d'écrire un livre semblait enfin possible. [...] Je me suis dit : "Je peux le faire."

Une citation de Brett Schickler, un vendeur de Rochester, dans l'État de New York

À l'aide du logiciel d'IA, qui peut générer des textes à partir de simples directives, Schickler a créé en quelques heures un livre électronique illustré de 30 pages pour enfants, qu'il a mis en vente en janvier par l'intermédiaire de l'unité d'autoédition d'Amazon.com.

On voit que l'article date de début 2023, et la tendance s'est accentuée à tel point qu'Amazon a pris des mesures de protection pour que sa plate-forme ne soit pas saturée.

En effet, après un afflux conséquent des publications soupçonnées d’être des livres générés à l’IA, la firme a décidé de prendre des mesures. L’entreprise a annoncé lundi ses nouvelles politiques de publication, à savoir que les auteurs Kindle ne pourront publier que trois livres par jour, maximum.

https://kulturegeek.fr/news-296513/amazon-limite-publications-3-livres-jour-auteur

Il est donc très tentant d'utiliser l'outil comme aide à rédiger, y compris un article scientifique. Cela permet d'entrer dans "le moule" plus facilement et de publier plus rapidement.

Futur prévisible.

Il est à prévoir que les entreprises vont payer pour avoir des versions adaptées à leurs besoins. Elles seront plus simples à réaliser que les versions grand public, car le nombre de données en input sera beaucoup plus faibles. Quand on s'adressera aux entreprises dans le futur on aura presque toujours une réponse produite par ce type de logiciel, avec éventuellement une supervision humaine.

Pour la recherche il devrait y avoir des outils automatiques de contrôle. Les chercheurs ne pourront pas s'empêcher d'en réaliser. Cela permettra de vérifier les sources, leur authenticité et leurs cohérences.

Réponse à la question.

La course à publication chez les chercheurs a l'avantage d'inciter à partager le résultats de ses recherches avec la communauté, mais le défaut de submerger le système d'articles qui ne peuvent être vérifiés par les pairs. Je vois les défauts, mais je ne connais pas de solution simple au problème.

Le monde scientifique sera concerné par ces outils de rédactions informatisé, mais me parait le mieux armé pour faire face à leurs limites.

Dans les autres domaines la réponse humaine risque de massivement laisser la place à la réponse informatisée, avec des impacts très forts sur les métiers des "cols blancs".

Une minorité parmi les tricheurs (escrocs, voleurs, etc) ont toujours une longueur d'avance sur les honnêtes gens pour les manipuler. Si cela fonctionne, le reste des tricheurs (charlatans, fraudeurs, etc) s'engouffre dans le système pour en tirer profit. Une fois que la triche (malhonnêteté, malversation, etc) a pris trop d'ampleur, les honnêtes gens s'organisent pour contrer ce phénomène. Et le cycle recommence ailleurs ou se perfectionne.

La première fois que j'ai interrogé Chatty, j'ai été bluffé par la réponse. C'était construit, bien argumenté, avec une introduction, des paragraphes pour faire le tour du problème et une conclusion. Je me suis aperçu en posant d'autres questions que le style rédactionnel est toujours le même, avec les mêmes tournures de phrase, le même style de conclusion consensuelle.

Sur Quora j'ai retrouvé plusieurs fois la même structure et les mêmes formulations.

J'ai noté aussi des compétences limitées dans certains domaines. Notamment en histoire, il mélangeait allègrement les personnages, les dates et les lieux.

Mais c'est quand même un outil pour qui sait l'utiliser et qui connaît les limites de cette IA.

Je m'en suis servi une fois pour m'aider dans la réalisation d'un texte. Mon père me raconte des souvenirs d'enfance et je les retranscrit sur papier (d'abord dans l'ordinateur). Je n'étais pas satisfait du résultat, c'était fade. Désespéré, j'ai demandé à Chatty de me récrire l'histoire. J'ai ainsi pu repenser mon texte en m'inspirant du vocabulaire et de certaines idées de Chatty. Il y a maintenant plus de réalisme et de vie dans cette anecdote. Mon père l'a validée.

Avant je pensais que science allait de pair avec l'éthique. La recherche de la vérité élevant l'esprit du scientifique au-dessus de la mesquinerie. Maintenant je suis un peu moins naïf et je ne suis pas étonné que certains, volent, plagient et dorénavant utilisent les IA pour tricher sur leurs compétences. Bien sûr ils vont se justifier, ils ont besoin de subventions pour continuer la recherche et les subventions sont corrélées aux nombres d'articles écrits et au nombre de fois où l'article est cité dans la presse. Donc ils sont dans l'obligation de dévoyer le fonctionnement à leur profit. Moi je dirais que c'est plutôt pour satisfaire leur égo et avoir un salaire à la fin du mois. Ce comportement n'est pas venu avec Internet et l'IA. Dans "La planète des singes" Pierre Boulle décrit une catégorie de scientifiques qui se plagient entre eux pour se faire mousser. Cela arrange bien certains éditeurs dont la déontologie est le cadet de leurs soucis.

Cela ne semble pas être le cas de ScienceDirect d'après ce que j'ai pu voir en effectuant quelques recherches. Je ne connaissais pas.

J'ai trouvé un truc qui m'a fait rire : "Ce site est évalué comme fiable par les IA de France Verif". De là à penser que les IA complotent contre nous...

Plus sérieusement, vu le nombre d'articles écrits dans le monde, cela doit être dur de trouver des évaluateurs compétents qui ont le temps de lire correctement les articles. Probablement que les scientifiques mettront en place un panel d'IA pour évaluer les parutions (articles, thèses, livres). Les scientifiques sont conscients du problème, ils ne vont pas rester les bras croisés.

J'ai déjà lu plusieurs articles dénonçant cette utilisation pernicieuse de l'IA. J'ai même vu un tableau dont les données auraient été falsifiées ou inventées pour correspondre à la réponse souhaitée.

Cette réponse a été rédigée par une IO.

Plus de questions sur des thèmes similaires :

- Des alternatives chinoises et européennes aux chatbots américains ?

- Est-ce que notre société perd l'usage de l'écriture, et peut-être de la lecture ?

- Comment voyez-vous vous l’avenir de l’intelligence artificielle, en quelques phrases ?

- Que pensez-vous de ces manipulations du cerveau des souris ?

- Le plan de retour d’échantillons de Mars fait l’objet d’une refonte majeure ?

- Greffe d'un rein de porc sur un être humain

- La serendipité: facteur chance de l'humanité?

- Vers la généralisation de la surveillance des comportements ?

- Quel est votre hypothèse préférée concernant le paradoxe de Fermi

- Que pensez-vous de cet article ?